AI時代に求められる新たなセキュリティ対策、進化したサイバー攻撃を防ぐには「人」への教育が必須

- セキュリティ

- 教育

- サイバー攻撃

- ../../../article/2024/09/knowbe4.html

AIの普及に伴い、AIサービスの安全性、つまりAIセキュリティに注目が集まっています。生成AIシステムの悪用や誤用、不正確な出力や情報漏洩などのリスクは、企業の信用や事業継続に深刻な影響を与えかねません。国内でも、AIガイドラインの策定や専門機関の設立が徐々に進みつつあり、AIを利用する企業・提供する企業の双方に、具体的な対策が求められるようになっています。

そこで今回は、セキュリティやネットワークの新規事業の開発・立ち上げに携わるSCSKとネットワンパートナーズ(NOP)の専門家にインタビューを実施。SCSKはNOPの親会社であるネットワンシステムズと2024年に経営統合を発表し、AIセキュリティをはじめとした最先端のセキュリティ領域でも協業を進めています。

本記事では、企業が抑えておくべきAIセキュリティの基本や国内外の市場動向、具体的なリスク、そして対応策についてわかりやすくまとめています。

目次

大須賀 孝之(おおすが たかゆき)氏

ネットワンパートナーズ株式会社

セールスエンジニアリング部

第一チーム エキスパート

【経歴】

インフラ系エンジニアとして従事後、Ciscoのマーケティングやビジネス開発に携わる。現在はビジネス開発の一環としてAIセキュリティ関連の商材探索に関与している。

尾崎 一平(おざき いっぺい)

ITインフラサービス事業グループ

セキュリティ事業本部

事業推進部 事業企画課 課長

【経歴】

ルーターやスイッチなどの基幹インフラ製品や、セキュリティプロダクトのエンジニアとして活動。数年前より、ネットワークやセキュリティの新規事業立ち上げのマネージャーを務める。

小林 遥香(こばやし はるか)

ITインフラサービス事業グループ

ITインフラサービス事業グループ統括本部

事業開発部 技術戦略課

【経歴】

NFTサービスの企画やAIセキュリティの商材に携った後、プロダクト営業やエンジニアとして経験を積む。現在は、AI技術の調査・普及、人材育成を担当している。

小林 今回インタビューを務めるSCSKの小林です。まずは、AIの業務活用が進む中で、AIに対して求められるセキュリティの基本的な考え方について、お二人の視点から教えていただけますか?

尾崎 基本はIPA(情報処理推進機構)が定義しているセキュリティの3要素―機密性、完全性、可用性―を、AIサービスにも適用することです。

機密性:情報漏洩を防ぎ、企業の信頼を守るための要素

完全性:データが改ざんされず、正確な状態を維持すること

可用性:システム障害が発生してもサービスを継続できる状態を維持すること

AIはもはや単なるツールではなく、企業インフラの一部になっています。だからこそ、この3要素を守りながら、安心安全に利用できる仕組みが求められます。

小林 なるほど、まずは従来のセキュリティの考え方をAIにも当てはめるわけですね。

尾崎 はい。さらに、AIは新しい機能や要素が次々に登場します。それに呼応するようにどんどんツールも増えてくるので、状況に合わせて必要なセキュリティを組み合わせることが重要です。

大須賀氏 加えて、AIセキュリティには2つの側面があります。ひとつは、ChatGPTやGeminiのようなサービスを使う「利用者側のセキュリティ」。もうひとつは、AIモデルやAIシステムを提供する「提供者側のセキュリティ」です。ユーザー目線だけでなく、提供者としてもリスクがあることを自覚し、両方の視点で対策を考える必要があります。

小林 確かにAI事業者ガイドライン(※1)でも、立場によって求められる対応が異なることが明記されていますね。

小林 AIは変化も激しいので市場の動きも速そうですね。最近の傾向についてどう見ていますか?

尾崎 生成AIの登場以降、AIの業務活用が一気に進みました。当初は「AIをどう使うか」に意識が向いていましたが、さまざまなリスクや脅威が明らかになってきた今、「AIは本当に安全な状態なのか」にも目が向けられるようになっています。

大須賀氏 実際、海外ではAIシステムのリスクをスコア化して、リスクの高い領域に対して優先的に投資するという考え方が浸透しています。AIがユーザー側の意図しない動きをすることで、企業の信用低下にもつながるため、設計段階からセキュリティを考慮するのが常識です。すでに北米やEUでは、NIST(※2)、OWASP(※3)などの国際的なセキュリティフレームワークも定められています。

小林 EUのAIアクト(AI規制法)は非常に話題になりましたね。

大須賀氏 はい。EUでは、GDPR(個人データの保護とプライバシー権を強化する法規則)によって個人情報の取り扱いが厳しく制限されているので、訴訟リスクが非常に高いです。そのため個人情報や機密情報を扱っている金融業界はより敏感になっています。

小林 日本市場の状況はいかがでしょうか?

尾崎 日本企業の50%がAI活用を進めているとして、その内AI特有のリスクへの対策を行っている企業は10%未満だと言われています。国内ではまだAIセキュリティ由来の大きな事故が起きていないこともあり、検討段階の企業が多いですね。一部の先行企業は、各ベンダーの製品の機能を試用しながら、既存のセキュリティ商材で対応できる範囲か、あるいは新たな投資が必要かを見極めている状況です。

大須賀氏 本格的な取り組みはこれからです。現在AI関連のプロジェクトで活躍されている方々はAIサービスの最適化をミッションとしてお持ちであり、AIセキュリティの専門家はほぼいません。投資判断でもAIの精度向上などの利益面が優先され、セキュリティ対策は後回しになっています。そういう意味では、今後のAIセキュリティの普及は、経営層の投資判断にも左右されるでしょう。

尾崎 とはいえ、変化の兆しはあります。AIセキュリティに関する制度や法律はまだありませんが、評価指標やモデルケースは出始めています。AIガバナンス協会(※4)やAISI(※5)が発足し、企業間でAI開発者のコミュニティ活動も活発化してきています。

大須賀氏 政府調達においても、AIに関する評価指標が導入され始めており、今後もAI利用に対してセキュリティ要素を組み込む流れは増えてきそうです。海外で先行するフレームワークを参考に、対策が進んでいくと思われます。

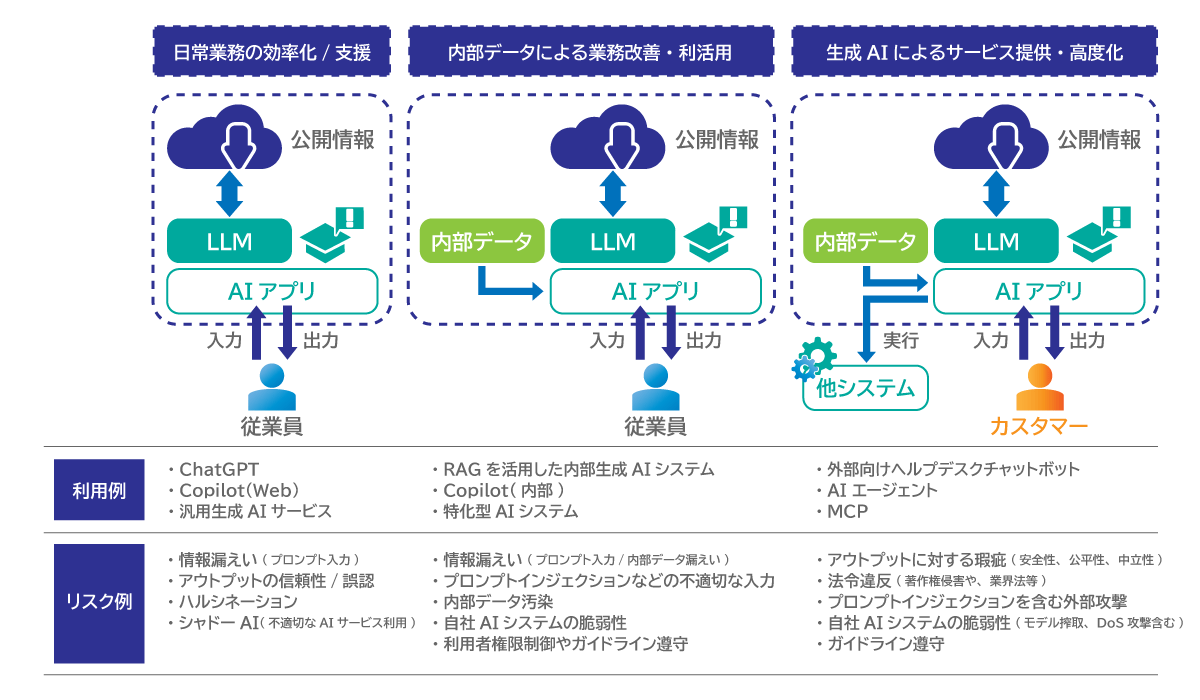

小林 企業が直面するAIリスクにはどのようなものがありますか?

尾崎 AIの進化に伴い新しいタイプのリスクが次々に出てきています。例えば生成AIでは、アウトプットに再現性がないため、課題の把握や検証が難しいという構造的な課題があります。また、通常のシステムがプログラム通りにしか動かないのに対し、AIエージェントは自律的に意思決定を行うので、システムの提供者やユーザーの意図を超えた行動を取る可能性があります。

生成AIやAIエージェントがシステムの提供者の想定通りに動作しているか、本来越えていけない領域に踏み込んでいないかを検知する仕組みが必要です。

大須賀氏 AIリスクには大きく分けて2種類、攻撃されるリスク(被害者になるリスク)と、攻撃してしまうリスク(加害者になるリスク)があります。AIが普及したことによって攻撃行為のコストやリスクが下がっており、ディープフェイクを使った詐欺をはじめ、高精度な攻撃が簡単に行えるようになりました。またAIを使う中で、誰もが思わぬ形でデータ漏洩やプライバシー侵害などを引き起こす可能性もあります。つまり企業は「守る」だけでなく、自分たちが加害者にならないための対策も重要です。

小林 それぞれのリスクについて具体的に教えてください。

尾崎 攻撃されるリスクとしては、AIシステム対する攻撃や情報の漏洩・改ざんが懸念されます。インタフェースを構えた時点で攻撃対象になるのは従来と同様です。

具体的な例としては、

今後、自社でAIのモデルを作成する動きが広がれば、上記のモデルの脆弱性や仕組みを狙った攻撃が増加すると考えられます。

一方で、攻撃に加担してしまうリスクでいうと、脆弱性のある生成AIサービスを公開してしまうことで、攻撃者に悪用される可能性があります。例えば、下記のようなケースがあります。

この結果、暴力的や差別的なコンテンツが生成され、知らないうちに利用されると、企業に深刻なブランドリスクをもたらします。さらに、生成AIと連携している他システムを不正操作するための経路となるケースもあります。

大須賀氏 すでに海外では、生成AIモデルが作成した動画が著作権侵害の疑いをもたれたケースや、AIによる誤った処理によって飛行機のチケットが手配できず訴訟に発展した事例も報告されています。日本でもコールセンターなどでAIサービスの活用は進んでいますが、深刻なトラブルや訴訟はまだ表面化していないだけで、リスクは確実に存在しています。

尾崎 AIインシデントデータベース(※6)など、様々なAIリスクを集約したサイトも日本語で提供され始めています。公表されていないだけで、インシデントが起きている可能性が高いと考えられます。

小林 今後、技術の進化でリスクはどうなるのでしょうか?

大須賀氏 間違いなく拡大します。例えば、AIエージェントが外部と連携する際に使われるMCPプロトコルなど便利な仕組みが増えますが、連携先から入ってくる情報の正当性は誰が担保するのかという課題が残ります。さらに、プレイヤーが続々と参入している中で、何に基づいて誰を信頼すればいいのかという問題が出ています。技術の進化によって利便性が上がる一方、セキュリティの脆弱性も増えていくのが現状です。

AI活用のイメージとリスク(参考)

小林 では、企業はどのような対策から始めればよいでしょうか?

尾崎 AIシステムやサービスの運用には、冒頭で述べたセキュリティの3要素を脅かすリスクへの対策が欠かせません。

まず一つ目は機密性です。情報が外部に流出すれば、損害賠償や技術の流出といった深刻な問題につながります。そのため、AIシステムが安全な運用を実現するために、モデルの保護、参照データや学習データの暗号化、アクセス制御と認証、出力内容の監査と社員教育の徹底が重要です。

次に、完全性です。外部からの攻撃やモデルに対する改ざんは、サービス停止や重大なトラブルを引き起こします。そのため、プロンプトの検証やフィルタ、参照・学習データの管理や、定期的なバックアップを行うことが求められます。

最後に可用性です。障害によるシステム停止は業務遂行の停滞や信用の損失、場合によっては事業サービスに対する重要な影響を及ぼします。これを防ぐためには、システムの冗長化や稼働監視によるDoS攻撃対策、定期的なバックアップが不可欠です。

これらの対策は従来のセキュリティでも重視されてきましたが、これからのAIセキュリティにおいても同様に追及していくべき重要なポイントです。

| リスク | 対策 | |

|---|---|---|

| 機密性 | 情報漏洩による信頼失墜や損害賠償、固有技術の流出 | モデルの保護、参照データや学習データの暗号化、アクセス制御と認証、出力内容の監査と社員教育の徹底 |

| 完全性 | 外部からの攻撃によるデータ改ざん、モデルに対する改ざんにによるサービス停止 | プロンプトの検証やフィルタ、参照・学習データの管理や、定期的なバックアップ |

| 可用性 | システム停止は業務遂行の停滞や信用の損失、事業サービスに対する重要な影響 | ステムの冗長化や稼働監視によるDoS攻撃対策、定期的なバックアップ |

大須賀氏 また、「シャドーAI」といわれる、企業の管理外で使用されているAIをしっかり把握することも重要です。クラウドが普及した時に問題となった「シャドーIT」と同様に、利用サービスや利用状況の統制が必要です。適切なユーザーに対して適切なアプリを適切なタイミングで使わせるルールが不可欠になります。

ただ、AI分野は技術の進化が非常に速く、共通のルールやガイドラインを一度作っても、すぐに現状の技術レベルに合わなくなるという課題があります。昨年の前提が今年は通用しないことも珍しくありません。そのため、企業は技術の進化に素早くキャッチアップしながら、ポリシーやガイドラインを継続的にアップデートしていく体制を整える必要があります。

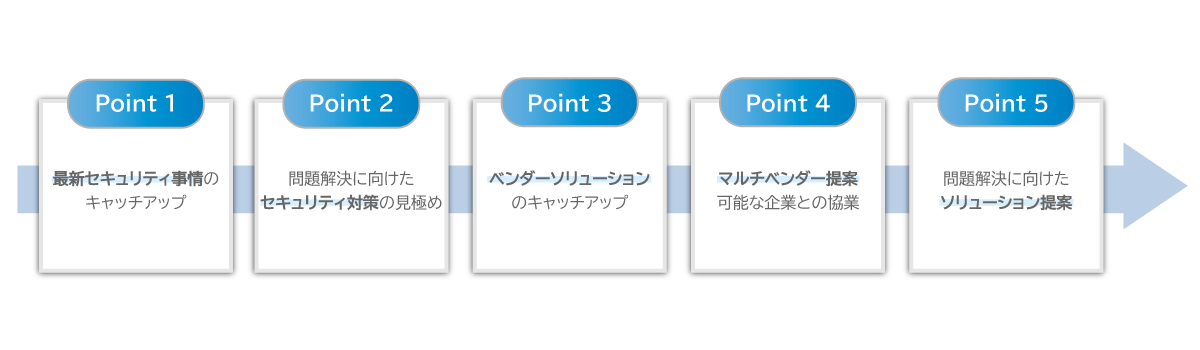

小林 SCSKとNOPとしてAIセキュリティ領域でどのような支援が可能なのでしょうか?

尾崎 先程お話しした通り、AIセキュリティは海外の方が先行しています。我々はディストリビューターとして数々の海外商材を日本に展開してきた実績がありますので、AIセキュリティ領域でも海外からの情報と製品を日本に展開する役割を担っていきます。現在は、AIセキュリティの啓蒙活動や検討を後押しする情報発信にも力を入れています。

一緒にビジネスを進めるパートナー様がエンドユーザーに最大限の価値を提供するためのご支援も我々の役割です。同時に、ベンダーとの関係を強化し、日本市場からのフィードバックを伝え続けていきます。

また、SCSKではAI活用とデータ統合を支援するオファリングサービス「NebulaShift ai」を提供しています。このサービスはAI導入に必要な基盤やツールをワンストップで提供し、業務適用まで伴走します。お客様ごとに最適なAI基盤を構築していく中で、AI特有のさまざまなリスクも考慮してご提案を行っています。

NebulaShift aiに関してはこちらもご覧ください:

「NebulaShift ai®」トップページ|AIの力でお客様のDXを促進する|SCSK株式会社

大須賀氏 弊社ではセミナーの開催などを通して、お客様の声を直接聞くことを大切にしています。「どこから着手すればいいかわからない」といったお客様には、SCSKと共同で伴走支援サービスもご提供させていただいます。SCSKの幅広い業界に対する提案経験とシステム構築運用の知見も借りながら、ハンズオンから他の製品のご提案含めて長くお付き合いさせていただけることが強みです。特定のフェーズだけ手伝ってほしいとのご依頼があればエンジニアを派遣させていただき、皆様のビジネスに最大限貢献できる体制をとっております。エンジニア不足によるロストをなくし、信頼関係を築くことでビジネス開発に寄与いたします。

伴奏支援サービスの流れ

SCSKとNOPのAIセキュリティソリューション(参考)

| ソリューション名 | 主な機能 | 解決する課題 | |

|---|---|---|---|

| SCSK | AI Firewall(A10社) |

|

|

| APrisma AIRS(パロアルトネットワークス社) |

|

|

|

| NOP | AI Access for Cisco Secure Access(Cisco社) |

|

|

| Cisco AI Defense(Cisco社) |

|

|

小林 今後、AIセキュリティに関してどのような取り組みをしていく予定ですか?

尾崎 今後1~2年でインパクトの大きいAIに関するセキュリティ事故・事件が出始めると予想しています。その時に製品を探している状態では遅く、次のインシデントを防げるような立場でいなくてはいけません。弊社の取扱製品があれば問題ないと言えることが僕らのいる理由ですね。

大須賀氏 弊社では「ネットワンオンネットワン」といわれる、社内で醸成したベストプラクティスをお客様に展開する取り組みしており、AIセキュリティの分野にもそれを適用していく流れになると思います。この先SCSKと協力し、新たな価値の提供やチャレンジを積極的に行っていきたいです。

※1 AI事業者ガイドライン AI事業者ガイドライン(METI/経済産業省)

※2 NIST AI Risk Management Framework AI Risk Management Framework | NIST

※3 OWASP Top 10 for Large Language Model Applications OWASP Top 10 for Large Language Model Applications | OWASP Foundation※4 AIガバナンス協会 AI Governance Association

※5 AISI Japan AISI - AI Safety Institute※6 AI Incident Database Welcome to the Artificial Intelligence Incident Database